はじめに:Claude Codeを無料で使いたい!

Anthropic社のClaude Codeは、AIがコードを読み書きし、ターミナルでコマンドを実行できる革新的なコーディングツールです。

しかし、Claude Codeを使うには有料プラン(Proプラン月額3,400円〜)が必要。「無料で使えないの?」と思う方も多いはず。

そこで今回、Ollamaを使ってローカルの無料AIモデルでClaude Codeを動かせるか、実際に検証してみました。

結論から言うと:技術的には動くが、実用性は厳しい。

その理由を、実験結果とともに詳しく解説します。

Ollama × Claude Code連携とは

Ollamaは、ローカルでLLM(大規模言語モデル)を動かせるオープンソースツールです。

2025年末、OllamaがAnthropicのAPI形式に対応したことで、Claude CodeのUIでOllamaのモデルを使えるようになりました。

公式ドキュメントの説明

Ollamaの公式ドキュメントでは、以下のように設定すればClaude Codeでローカルモデルが使えると説明されています:

# 環境変数を設定

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_BASE_URL=http://localhost:11434

# Claude Codeを起動

claude --model gpt-oss:20b推奨モデルとして以下が挙げられています:

- gpt-oss:20b – 汎用モデル(13GB)

- gpt-oss:120b – 大規模汎用モデル(65GB)

- qwen3-coder – コーディング特化モデル

「これなら無料でClaude Codeが使える!」と期待して、実際に検証してみました。

検証環境

| 項目 | スペック |

|---|---|

| マシン | MacBook Pro M4 Max |

| メモリ | 128GB |

| Claude Code | v2.1.17 |

| Ollama | 最新版 |

| 検証モデル | gpt-oss:20b、gpt-oss:120b |

※128GBメモリというハイスペック環境での検証です。一般的なPCではさらに厳しい結果になる可能性があります。

検証1:gpt-oss:20b(13GBモデル)

セットアップ

まず、比較的軽量な20Bモデルで試してみました。

# Ollamaサーバー起動

ollama serve

# 別ターミナルでClaude Code起動

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_BASE_URL=http://localhost:11434

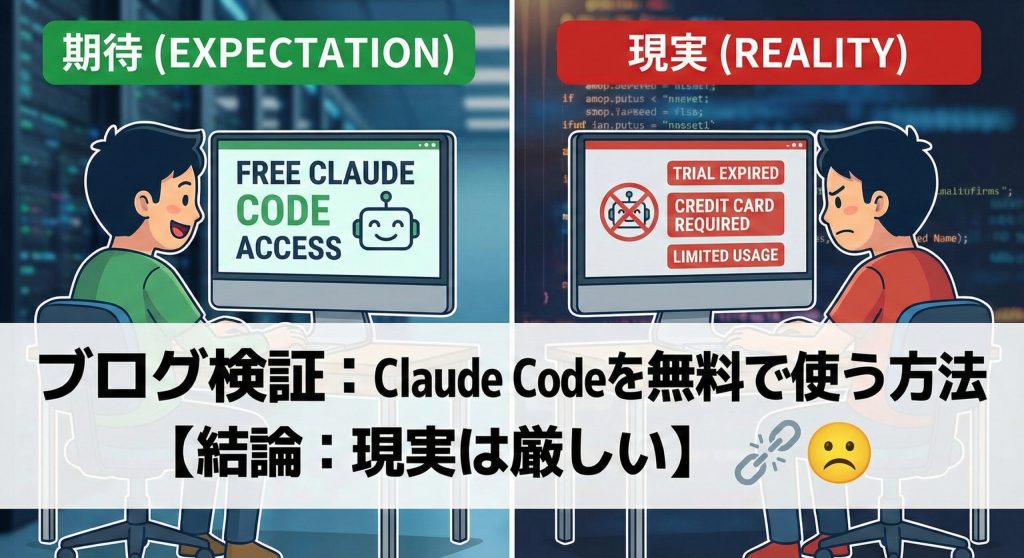

claude --model gpt-oss:20b結果:起動は成功

Claude CodeのUIが立ち上がり、モデルが「gpt-oss:20b」と表示されました。

簡単な挨拶には応答できました:

こんにちは!今日はどのようなお手伝いをいたしましょうか?

メモリ使用量

Ollamaが約13.5GBのメモリを消費。20Bモデルとしては妥当な数値です。

実際のコーディングタスクを依頼

では本題。実際にコードを書いてもらいましょう。

カウントダウンタイマーのRemotionコンポーネントを作成して。

10秒からカウントダウンして0になったら「TIME'S UP!」と表示する。

デザインはモダンでかっこよくして。結果:タスク失敗

⎿ Error searching files

⏺ I'm ready to help. What would you like to do next?

✻ Cogitated for 53s53秒考えた結果、ファイル検索でエラーが発生し、「何をしますか?」と聞き返されて終了。

コードは一切生成されませんでした。

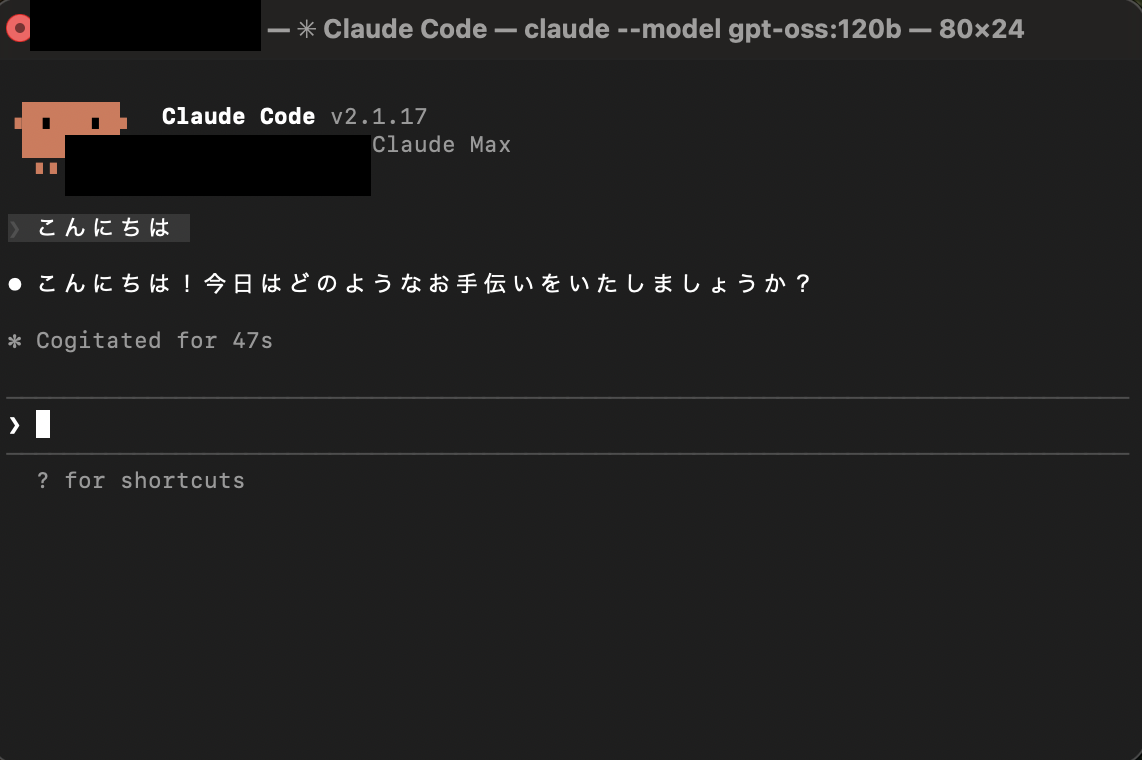

検証2:gpt-oss:120b(65GBモデル)

「モデルサイズが小さいから失敗したのでは?」と考え、6倍大きい120Bモデルで再挑戦。

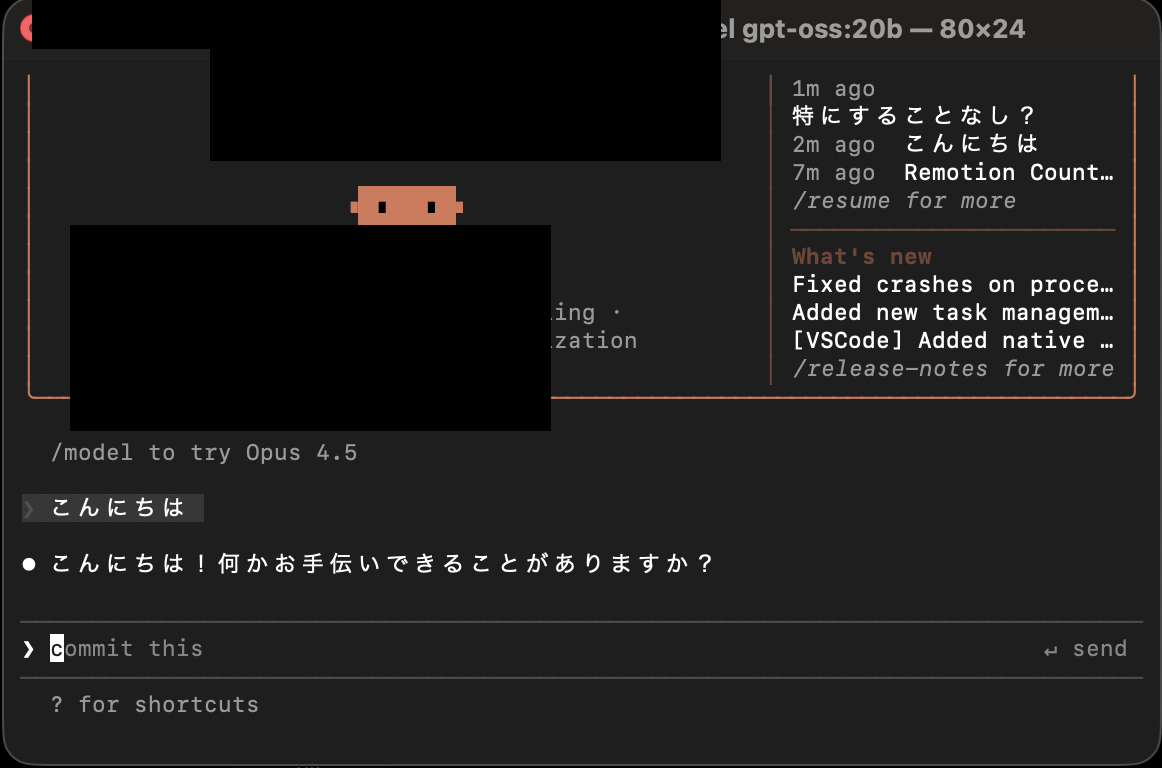

メモリ使用量:衝撃の61GB

Ollamaのメモリ使用量が約61GBに跳ね上がりました。

システム全体で128GB中61GBを使用。一般的なPC(8〜16GBメモリ)では絶対に動きません。

応答速度:簡単な挨拶に47秒

❯ こんにちは

⏺ こんにちは!今日はどのようなお手伝いをいたしましょうか?

✻ Cogitated for 47sたった一言の挨拶に47秒。本家Claude Code(Opus 4.5)なら1秒未満で返答します。

コーディングタスクの結果

❯ カウントダウンタイマーのRemotionコンポーネントを作成して...

⏺ How can I assist you with your software engineering task?

✻ Churned for 1m 26s1分26秒かけて「何を手伝いましょうか?」と返答。

120Bモデルでも、コードは一切生成されませんでした。

なぜ動かないのか?技術的な解説

Claude Codeの仕組み

Claude Codeは単なるチャットボットではありません。内部でTool Use(関数呼び出し)という機能を使っています。

- ファイルを読む → Read Tool

- ファイルを書く → Write Tool

- コマンド実行 → Bash Tool

- ファイル検索 → Glob/Grep Tool

AIがこれらのツールを適切に呼び出すことで、実際のコーディング作業が可能になります。

問題:オープンモデルはTool Useに非対応

gpt-ossやqwen3などのオープンモデルは、Anthropic独自のTool Use形式で訓練されていません。

そのため:

- チャット応答 → 可能(普通の会話はできる)

- ツール呼び出し → 不可能(形式を理解できない)

- ファイル操作 → 失敗(ツールが使えないため)

結果として、Claude CodeのUIは表示されるものの、コアの機能が動作しない状態になります。

検証結果まとめ

| 項目 | gpt-oss:20b | gpt-oss:120b | 本家 Opus 4.5 |

|---|---|---|---|

| メモリ使用量 | 13.5GB | 61GB | クラウド実行 |

| 挨拶の応答時間 | 数秒 | 47秒 | 1秒未満 |

| コーディングタスク | 失敗 | 失敗 | 成功(1分で完了) |

| ツール使用 | エラー | 無視される | 完全対応 |

| 実用性 | × | × | ◎ |

結論:Claude Codeは本家を使うのが現実的

無料で使いたい気持ちはわかるが…

OllamaとClaude Codeの連携は技術的には可能です。UIは表示され、簡単な会話もできます。

しかし、Claude Codeの真価であるファイル操作・コード生成・コマンド実行は動作しません。

ローカルモデルの現実

- 20Bモデル:13GBメモリ必要、タスク完了できず

- 120Bモデル:61GBメモリ必要、それでもタスク完了できず

- 応答速度:本家の数十倍遅い

おすすめの選択肢

- Claude Code本家(Proプラン月額3,400円〜)

- 全機能が完璧に動作

- Opus 4.5の高品質なコード生成

- 高速レスポンス

- 無料でAIコーディングしたい場合

- Claude.ai無料枠でコードを相談

- GitHub Copilot無料枠

- Cursor無料枠

最後に

「無料でClaude Codeを使う」という夢は、現時点では実現困難です。

将来的にオープンモデルがAnthropicのTool Use形式に対応すれば状況は変わるかもしれませんが、今のところは本家Claude Codeを使うのが最も効率的です。

月額3,400円で得られる生産性向上を考えれば、投資する価値は十分にあると思います。